Para empezar, debo disculparme por usar en este texto un acrónimo desde el título y, doblemente, por usar la forma anglófona para ello. Bien podría haberse denominado CP/IA, pero consiénteme, lector, este fútil ejercicio estético fruto de mi época y complejos.

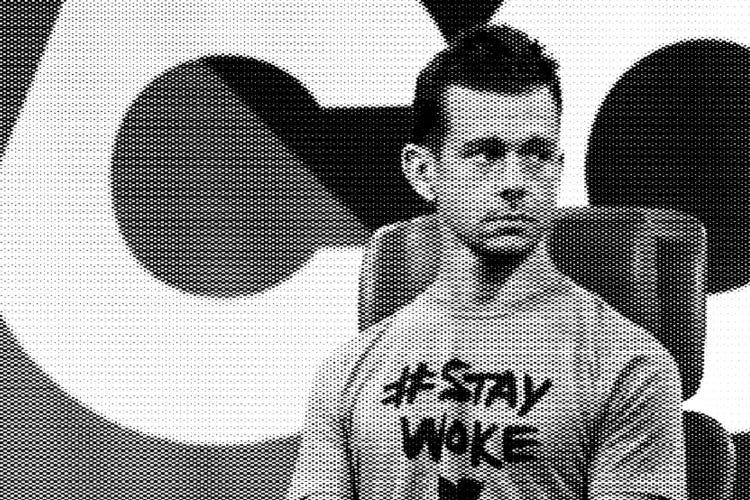

Las dos primeras letras, como imaginarás, responden a Artificial Intelligence (Inteligencia Artificial), sobre la cual escribí tangencialmente para estrenar este cuaderno. Las dos segundas responden a Political Correctness (corrección política). Y es en este segundo par, de uso más habitual en la anglosfera, donde nos detendremos brevemente a comentar su origen. Y lo haré más allá del imperdible Director PC de la serie South Park, epítome del hombre blanco 'aliade' de izquierdas ampliamente ridiculizado hasta en la asamblea de su barrio y archienemigo del angry white male salido del gimnasio, antorcha tiki en mano pensando que 'alguien' quiere reemplazarlo 24/7. Dos lados de una moneda tristemente aplastada y afilada por el imparable tren de la postmodernidad.

Y es que como explicaba un artículo del Washington Post por allá en 2016, el término ‘Políticamente Correcto’ pasó de ser un cumplido a un insulto, como suele ocurrir con bastantes conceptos resignificados con el paso de los años y tras el desgaste de las batallas ideológicas.

Así pues, si durante la primera mitad del siglo XX se empleaba para describir una actitud respetuosa y consciente hacia los grupos marginados, fomentando la inclusión y evitando el lenguaje ofensivo, durante la segunda mitad y con la extensión del marxismo como sistema alternativo, pasó a ser empleado primero para definir a alguien cuya lealtad al Partido Comunista (otra vez PC) le llevaba a ser dogmático, ya que primaba la ortodoxia sobre la moral. Para finalmente, ser utilizado en los campus norteamericanos de los 70 como punta de lanza del deconstruccionismo contra las grandes narrativas. Fue el comienzo de las odiosas e irónicas comillas en el aire, que todos tenemos integradas en nuestro sistema operativo de lenguaje corporal.

Así pues, actualmente equiparamos lo PC a lo woke, aunque no sea exactamente lo mismo, o hablamos de la ‘política de la cancelación’ la cual también responde nuevamente a las siglas PC, pero se trata de una derivada de esta misma, una versión renovada y zurda del huevo o la gallina.

Y esta modesta, y espero que esclarecedora, introducción me permite generar, fruto de un prompt in promptu, la definición de ‘Artificial Intelligence Political Correctness’ (AI/PC).

Por un lado podríamos entender la AI/PC como una nueva disciplina surgida de las entrañas de Sillicon Valley, que garantice que los sistemas de AI y las tecnologías relacionadas sean desarrollados y utilizados de manera ética y respetuosa, evitando el sesgo, la discriminación y el perjuicio hacia grupos vulnerables. Aunque, por otro lado ya sabemos que ocurre cuando los chicos del valle de la silicona ponen sus manos sobre lo que ellos no consideran políticamente correcto y no me extenderé sobre ello.

En todo caso, este tipo de sesgos se anunciaron ya por 2017 en el artículo de Adam Hadhay “Biased bots: Artificial-intelligence systems echo human prejudices” para la Universidad de Princeton, el cual provocó sendos artículos en Wired y The Guardian, En él, se reflexiona que, a pesar de su objetivo de imparcialidad, los algoritmos de AI son entrenados utilizando conjuntos de datos que reflejan las inequidades y sesgos existentes en la sociedad. Para aquellos que estéis interesados en ampliar este tema, investigad sobre el ‘test de asociación implícita’ y sacad el tema en la próxima reunión de amigos justo antes del café.

Y es que ahí radica la clave, justamente en estos conjuntos de datos, también conocidos por su término en inglés como ‘datasets’. Sabemos que la carrera de la AI acaba de empezar, y que los países/empresas que tienen acceso a poder computacional, ingenieros y grandes cantidades de datos han tomado la delantera, con una ventaja abrumadora de la iniciativa publico-privada de EEUU y China en concreto, y del primer mundo en general. Estas superpotencias deforman una vez más el mapa de influencia imponiendo el uso de sus datos, o, por decirlo de otra manera, imponiendo el código de fuente de sus narrativas, primero con misiles y drones, y ahora con chatbots y recomendaciones.

Desde el Internet Health Report de 2022 dicen:

“¿Por qué no utilizar otros conjuntos de datos? Los modelos y conjuntos de datos de aprendizaje automático reflejan tanto los prejuicios de sus creadores como las dinámicas de poder que están profundamente arraigadas tanto en las sociedades como online, pero esto no es ampliamente reconocido. Se deberían crear más conjuntos de datos específicamente para diversificar los métodos de machine learning en aras de la igualdad”.

Y este es el sueño roto al que me refería hace ya algunas semanas en el primer artículo de este cuaderno: la descentralización de la futura Web3 o lo que venga posteriormente es imposible si unos pocos actores siguen controlando el juego.

¿Por qué no se ha popularizado el uso de la Dark web o de las Darknets, más allá de su supuesta peligrosidad tantas veces anunciada? Porque la gente se aburre, no sabe como acceder o navegar por ella. Algo parecido ocurrió en los inicios de Internet antes de la popularización de los buscadores; era atractivo solo para ciertas partes de la subcultura hacker y los pioneros que navegaban sin saber muy bien qué buscar. En cambio, hoy en día, internet significa Google, Meta, Baidu, Amazon y Aliexpress, con permiso de las plataformas de streaming y de la pornografía online.

Son estos actores, con la ayuda necesaria de los países desde los que operan, los que controlan no solo la narrativa, ni tampoco únicamente nuestros deseos y afectos, sino también los márgenes de lo que debe ser pensado, ya sea por el éxito de sus respectivos modelos de negocio o por la pereza mental que ha afectado al muy respetable público, lo que hace extremadamente difícil pensar desde fuera.

Si a esto le sumamos que las AI suenan más articuladas que el tertuliano medio, debido principalmente a los datasets que utilizan, como bien explica este otro artículo del Washington Post, vampirizando datos desde la página de patentes de Google hasta la Wikipedia, entenderemos que es suficiente para que el público se las tome más en serio, en un ejercicio exagerado de humanización de la tecnología, como si de un organismo autónomo se tratase.

Además, esta nueva revolución industrial, como todas las anteriores tiene y tendrá sus víctimas, como los trabajadores de la empresa Sama, subcontratada en Kenia por OpenAI, para ayudar a la empresa californiana en el etiquetado de contenidos. Los trabajadores de esta empresa cobraban menos de dos dólares al día por su trabajo de moderación, según una investigación de la revista Time.

La AI ha elevado tanto el nivel de juego, que la forma en que estos conglomerados registran nuestros movimientos online, así como analizan y predicen comportamientos, está muy por delante de la legislación vigente, creando cámaras de eco segmentadas que no piensan en aras del usuario cautivo en la plataforma, sino en interés de los anunciantes.

Los sistemas de recomendación han llegado hasta tal punto que según un estudio conducido por Mozilla sobre Youtube, el 71% de los usuarios ven los vídeos que la plataforma les recomienda, un 22% viene referenciado por links externos de redes u otras plataformas y sólo un 7% lo que busca directamente. Eso sí, si preguntamos a los mismos usuarios, dirán que detestan las recomendaciones, pero las siguen consumiendo mientras consideran superado el sistema de televisión lineal. Tienen, al fin y al cabo, la sensación de elección en un simulacro controlado de link-zapping donde las cartas siempre están marcadas por la AI, aunque no lo puedan ver.